Claude, Gemini ou Mistral : comment choisir le modèle d'IA qui répond précisément aux enjeux opérationnels et budgétaires des dirigeants de PME

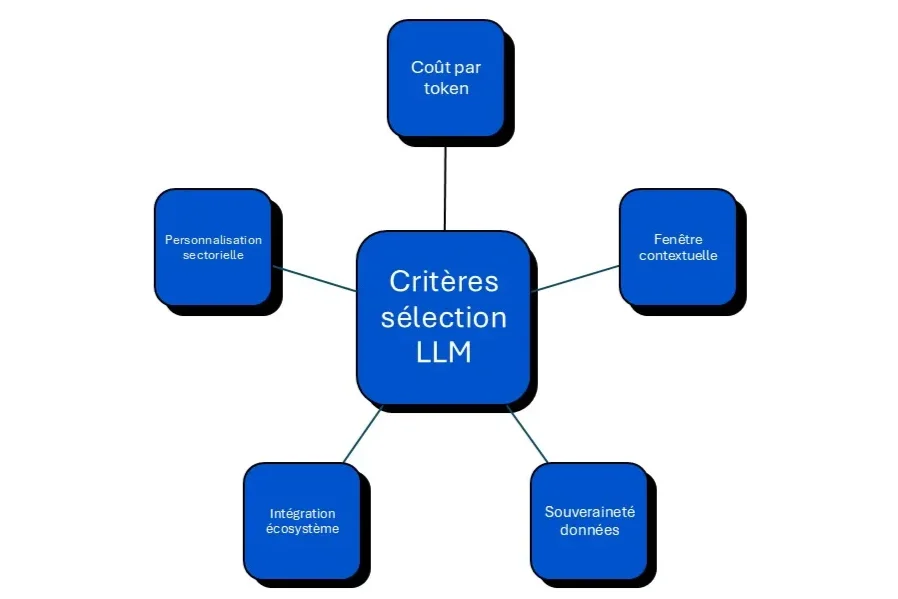

Votre équipe commerciale passe 6 heures par semaine à rédiger des propositions client répétitives ? Vous envisagez ChatGPT, mais vous vous demandez si d'autres solutions d'IA générative offrent un meilleur compromis performance-prix pour votre contexte métier. Les alternatives à ChatGPT se multiplient et proposent des modèles de langage (LLM) adaptés aux contraintes spécifiques des PME : coûts maîtrisés, souveraineté des données, ou personnalisation sectorielle. Choisir le bon outil devient un enjeu stratégique pour optimiser votre productivité sans dérive budgétaire.

Claude, développé par Anthropic, s'impose comme l'alternative ChatGPT privilégiée pour les usages métier exigeants en raisonnement et analyse. Les dirigeants de PME apprécient sa capacité à générer des contenus nuancés, avec un ton naturel qui facilite les échanges complexes. Contrairement à ChatGPT, Claude affiche une fenêtre contextuelle de 200 000 tokens, soit l'équivalent de 500 pages A4 traitées simultanément.

Le modèle se distingue par trois atouts majeurs pour les PME :

Les entreprises de conseil et les cabinets juridiques rapportent un gain de productivité de 18 à 24% sur la production documentaire grâce à Claude. Cette performance repose sur une architecture optimisée pour le raisonnement long, particulièrement adaptée aux analyses stratégiques ou aux synthèses réglementaires. Pour maximiser l'impact de votre démarche IA, découvrez nos 10 applications concrètes de l'IA générative pour optimiser votre stratégie marketing.

Google Gemini représente une alternative ChatGPT directement intégrée à l'univers Google Workspace, ce qui constitue un avantage décisif pour les PME déjà équipées de Gmail, Drive et Sheets. Cette intégration native élimine les ruptures de flux entre outils, avec un accès immédiat aux données stockées dans votre environnement Google. Gemini 1.5 Flash affiche un tarif particulièrement compétitif de 0,35 $ par million de tokens en entrée, soit 10 fois moins cher que les modèles premium.

Les performances mesurées positionnent Gemini comme une solution polyvalente :

Cette polyvalence technique permet aux PME de centraliser leurs besoins en IA générative sur une seule plateforme, réduisant ainsi les coûts de formation et les frictions organisationnelles. Les entreprises de retail et de services client enregistrent une diminution de 22 à 28% du temps de traitement des requêtes multicanales grâce à l'architecture multimodale de Gemini.

Mistral AI incarne l'alternative ChatGPT européenne pour les dirigeants de PME sensibles à la souveraineté des données et aux enjeux de conformité RGPD. Cette startup française propose des modèles à poids ouverts (Mistral 7B, Mixtral) qui permettent un hébergement local sur vos propres serveurs, garantissant ainsi une maîtrise totale de vos flux d'information. Mistral Large 2 affiche un coût de 3 $ par million de tokens en entrée, soit 15% moins cher que GPT-4.

L'approche open source de Mistral ouvre trois leviers stratégiques :

Les PME industrielles et les cabinets de conseil rapportent une réduction de 30 à 40% des coûts d'utilisation en optant pour un déploiement hybride Mistral (cloud API + hébergement local). Cette flexibilité technique s'avère particulièrement pertinente pour les entreprises manipulant des données sensibles ou soumises à des obligations réglementaires strictes.

Cette diversité de modèles soulève désormais la question de leur impact financier mesuré et de leur intégration concrète dans vos processus métier.

Le choix d'une alternative ChatGPT repose sur un arbitrage précis entre puissance de calcul et maîtrise budgétaire. Les modèles premium (Claude 3 Opus, GPT-4 Turbo) génèrent des coûts dépassant 30 à 50 $ par million de tokens en sortie, tandis que les versions optimisées (Mistral Small, Gemini Flash) oscillent entre 0,50 $ et 1,50 $. Pour une PME traitant 10 millions de tokens mensuels (environ 7 500 pages A4), l'écart budgétaire annuel peut atteindre 3 600 à 5 400 €.

Voici les seuils de rentabilité observés selon les profils d'usage :

La clé réside dans l'analyse de votre consommation réelle. Une entreprise de marketing digital génère en moyenne 12 à 18 millions de tokens mensuels pour ses campagnes de contenu automatisées, tandis qu'un cabinet de conseil atteint 3 à 7 millions sur des usages ponctuels. Mesurez votre consommation sur 30 jours avec un outil freemium avant de vous engager sur un abonnement annuel.

La question de la maîtrise des données constitue un critère discriminant pour 68% des dirigeants de PME européennes interrogés sur leurs freins à l'adoption des LLM. Les modèles propriétaires (ChatGPT, Claude API) imposent un transfert de vos données vers les serveurs du fournisseur, ce qui soulève des enjeux de confidentialité et de conformité. À l'inverse, les solutions open source comme Mistral 7B ou LLaMA 2 permettent un déploiement on-premise, garantissant que vos informations sensibles ne quittent jamais votre infrastructure.

Trois niveaux de sécurité se dessinent selon votre activité :

Les PME du secteur juridique, financier ou médical doivent privilégier les architectures hybrides ou les modèles open source pour respecter les obligations réglementaires. Un cabinet d'avocats manipulant des dossiers clients confidentiels ne peut risquer une exposition sur des serveurs tiers, même avec des garanties contractuelles. Pour approfondir les enjeux de gouvernance, consultez notre analyse sur la gouvernance et l'éthique de l'IA agentique.

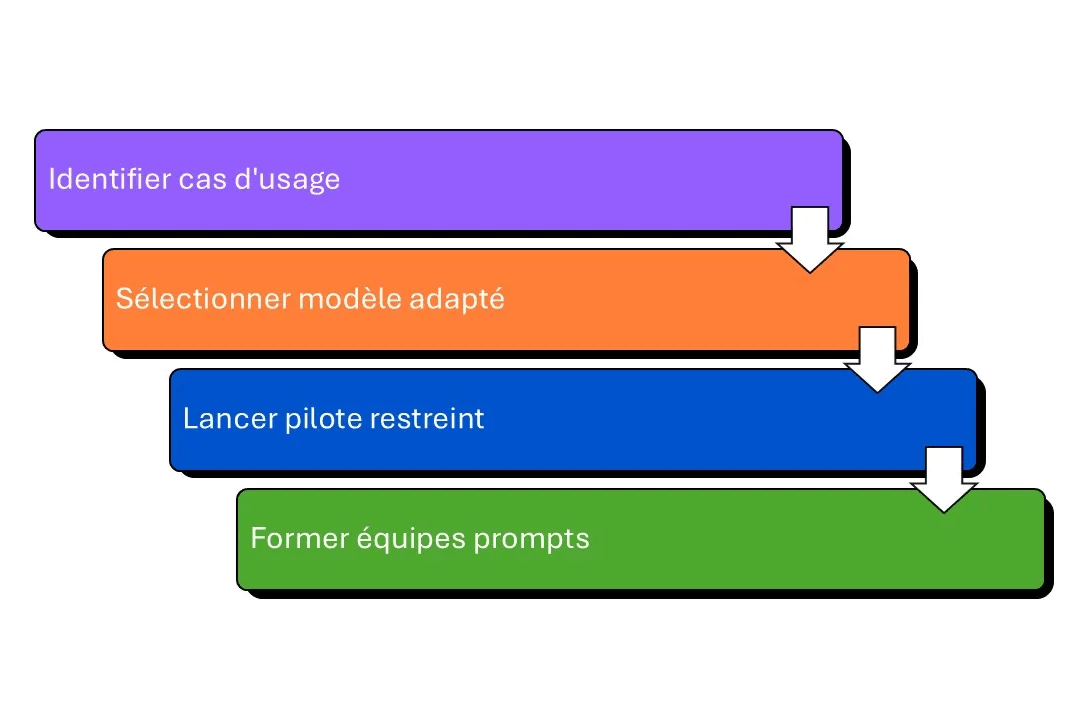

L'avantage décisif des modèles open source réside dans leur capacité à être ajustés sur vos données métier spécifiques. Un LLM générique comme ChatGPT performe correctement sur des tâches transverses, mais peine à intégrer le vocabulaire technique, les processus internes ou les référentiels normatifs de votre secteur. Le fine-tuning d'un modèle Mistral ou LLaMA sur votre corpus documentaire améliore la pertinence des réponses de 35 à 50% sur les cas d'usage métier.

Les étapes concrètes pour personnaliser un LLM open source :

Les PME industrielles ayant déployé un Mistral 7B ajusté sur leurs procédures de maintenance rapportent un taux de résolution autonome de 72% contre 41% avec ChatGPT générique. Cette personnalisation transforme le LLM en assistant métier véritablement opérationnel, capable de répondre à des questions techniques pointues sans intervention humaine.

Cette capacité d'adaptation sectorielle ouvre la voie à des stratégies d'implémentation progressives et mesurables pour maximiser votre retour sur investissement.

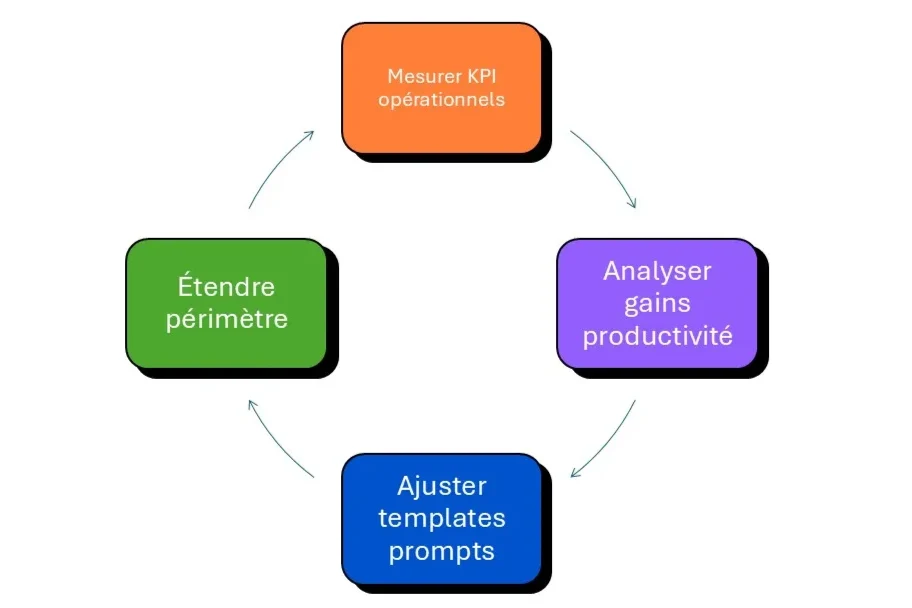

L'erreur classique des dirigeants de PME consiste à déployer une alternative ChatGPT sur l'ensemble de l'organisation sans validation préalable. Cette approche génère confusion, résistance au changement et échec d'adoption. La méthodologie éprouvée repose sur un périmètre pilote de 3 à 5 utilisateurs pendant 60 jours, ciblant un cas d'usage à fort impact mesurable : rédaction de propositions commerciales, support client niveau 1, ou génération de contenus marketing.

Critères de sélection d'un cas d'usage pilote réussi :

Une PME de services B2B a testé Claude sur la rédaction de réponses aux appels d'offres pendant 8 semaines. Résultat mesuré : temps de production réduit de 42%, taux de réussite des propositions stable, économie estimée de 12 000 € sur 6 mois. Ce pilote a permis de valider le ROI avant d'étendre l'usage à 18 collaborateurs supplémentaires.

La performance d'un LLM dépend à 60% de la qualité des instructions fournies par l'utilisateur. Un prompt mal formulé génère des réponses génériques, imprécises ou hors sujet, annulant les gains de productivité espérés. Les PME performantes investissent 2 à 3 jours de formation initiale pour transmettre les fondamentaux du prompt engineering : structuration des consignes, contexte métier, format de sortie attendu, et exemples de référence.

Les bonnes pratiques de prompt pour dirigeants de PME :

Les entreprises qui déploient des templates de prompts standardisés par cas d'usage constatent une amélioration de 25 à 35% de la qualité des sorties LLM en 4 semaines. Cette standardisation réduit également la charge cognitive des collaborateurs, qui peuvent réutiliser des structures éprouvées plutôt que de formuler chaque requête depuis zéro. Pour réussir l'intégration de ces nouveaux outils, explorez nos stratégies d'accompagnement au changement et adoption de l'IA dans la culture d'entreprise.

L'adoption d'une alternative ChatGPT doit se traduire par des gains mesurables sur vos indicateurs métier. Les dirigeants de PME sous-estiment souvent la nécessité d'instrumenter leurs cas d'usage pour quantifier l'impact réel. Sans mesure, impossible de justifier l'investissement ni d'identifier les axes d'optimisation. Les KPI pertinents varient selon votre activité, mais trois catégories émergent systématiquement : gains de temps, réduction de coûts, et amélioration qualitative.

KPI essentiels à tracker pour mesurer le ROI de votre LLM :

Une PME de e-commerce utilisant Gemini pour ses fiches produits a mesuré un gain de 8,5 heures/semaine par rédacteur, un coût LLM de 45 €/mois contre 1 200 € de coût salarial équivalent, et un taux d'acceptation de 78% après ajustement des prompts. Le ROI financier atteint 3,7× en 6 mois, hors gains indirects sur la réactivité commerciale et la cohérence éditoriale.

Avez-vous identifié le processus de votre PME qui bénéficierait d'une automatisation intelligente immédiate ?

Vous souhaitez structurer votre stratégie d'adoption des LLM avec un diagnostic data personnalisé ?

Discutons-en.

Flowt vous accompagne dans l'intégration de l'IA générative, de la Data Science et de la Business Intelligence pour transformer vos données en avantage concurrentiel mesurable.

Vous souhaitez être accompagné pour lancer votre projet Data ou IA ?