Entre 2015 et 2025, nous avons assisté à l'émergence de systèmes capables de battre les meilleurs joueurs humains, de générer du contenu créatif et de révolutionner des secteurs entiers de l'économie. Cette période charnière a vu naître les fondations de l'IA moderne, passant de promesses technologiques à des applications concrètes touchant près de 49% des entreprises en 2024.

L'analyse de cette évolution révèle non seulement les prouesses techniques accomplies, mais aussi les défis sociétaux et économiques qui redéfinissent notre avenir numérique. Chaque année de cette décennie a apporté ses ruptures spécifiques, créant un effet domino d'innovations qui continue de s'amplifier aujourd'hui.

.webp)

.jpg%20(1).webp)

Le tableau suivant synthétise les ruptures technologiques majeures de cette période :

Cette progression révèle une accélération constante, où chaque innovation pose les bases des suivantes, créant un momentum d'innovation autoentretenu qui caractérise notre époque.

L'année 2015 marque un tournant décisif avec le lancement de TensorFlow par Google, un framework de seconde génération corrigeant les limitations de DistBelief, leur système interne. Cette infrastructure puissante transforme radicalement l'écosystème de l'IA en offrant un système scalable, flexible et production-ready capable de gérer des milliers de cœurs de calcul dans les datacenters. TensorFlow apporte une architecture unifiée pour l'expérimentation et le déploiement à grande échelle.

Les facteurs clés de cette maturation technique incluent :

Cette révolution infrastructurelle s'accompagne d'une transformation dans l'accessibilité des ressources computationnelles. Les plateformes cloud proposent désormais des GPU haute performance à la demande, éliminant les barrières d'entrée financières qui limitaient auparavant la recherche en IA aux organisations les mieux dotées. Cette combinaison d'outils puissants et de puissance de calcul accessible crée un environnement propice à l'innovation distribuée.

L'impact d'AlexNet en 2012 se prolonge durant cette période, validant définitivement l'approche des réseaux de neurones profonds. Les architectures CNN se perfectionnent, bénéficiant de l'augmentation exponentielle de la puissance de calcul des GPU et de la disponibilité croissante de données d'entraînement. Cette infrastructure technique robuste pose les bases des révolutions à venir, créant un écosystème favorable à l'innovation rapide.

L'émergence de frameworks complémentaires comme PyTorch en 2016 vient enrichir l'écosystème TensorFlow, offrant aux développeurs des approches alternatives adaptées à différents styles de programmation. PyTorch privilégie la définition dynamique de graphes et une syntaxe plus pythonique, tandis que TensorFlow excelle dans le déploiement production. Cette diversification des outils accélère l'expérimentation et permet à des communautés variées de contribuer aux avancées de l'IA.

Les piliers de cette infrastructure technique robuste comprennent :

La combinaison de ces facteurs génère une dynamique d'innovation collaborative. Les universités, startups et géants technologiques convergent vers des objectifs communs, accélérant le rythme des découvertes et réduisant le temps entre recherche fondamentale et applications pratiques. Cette période voit également l'émergence de conférences spécialisées (NeurIPS, ICML, ICLR) comme lieux d'échange essentiels pour la communauté.

Le 9 mars 2016, le monde assiste à un moment historique lorsque AlphaGo bat Lee Sedol, l'un des meilleurs joueurs de Go au monde, par 4 victoires à 1. Cette prouesse dépasse largement le cadre ludique pour devenir un symbole de la maturité de l'intelligence artificielle.

Le Go présente des défis uniques qui en font un terrain d'évaluation idéal pour l'IA moderne. Avec plus de positions possibles que d'atomes dans l'univers observable, ce jeu millénaire requiert intuition, créativité et planification à long terme - des qualités traditionnellement considérées comme exclusivement humaines.

Les caractéristiques qui rendent le Go particulièrement complexe :

L'architecture d'AlphaGo combine apprentissage supervisé sur 160 000 parties humaines et apprentissage par renforcement via l'auto-confrontation. Cette approche hybride révèle le potentiel des systèmes capables d'apprendre à la fois des experts humains et de leur propre expérience.

L'impact médiatique de cette victoire amplifie considérablement la visibilité de l'IA auprès du grand public. Des millions de spectateurs suivent les parties en direct, découvrant pour la première fois les capacités réelles de l'intelligence artificielle moderne. Cette exposition massive sensibilise l'opinion publique aux enjeux de l'IA et stimule l'intérêt pour ces technologies.

Les retombées de la victoire d'AlphaGo s'étendent bien au-delà du jeu :

La victoire d'AlphaGo démontre que l'IA peut désormais exceller dans des domaines nécessitant créativité, intuition et pensée stratégique à long terme. Cette percée ouvre la voie à des applications dans la planification complexe, l'optimisation de ressources et la prise de décision en environnement incertain, domaines cruciaux pour les entreprises modernes.

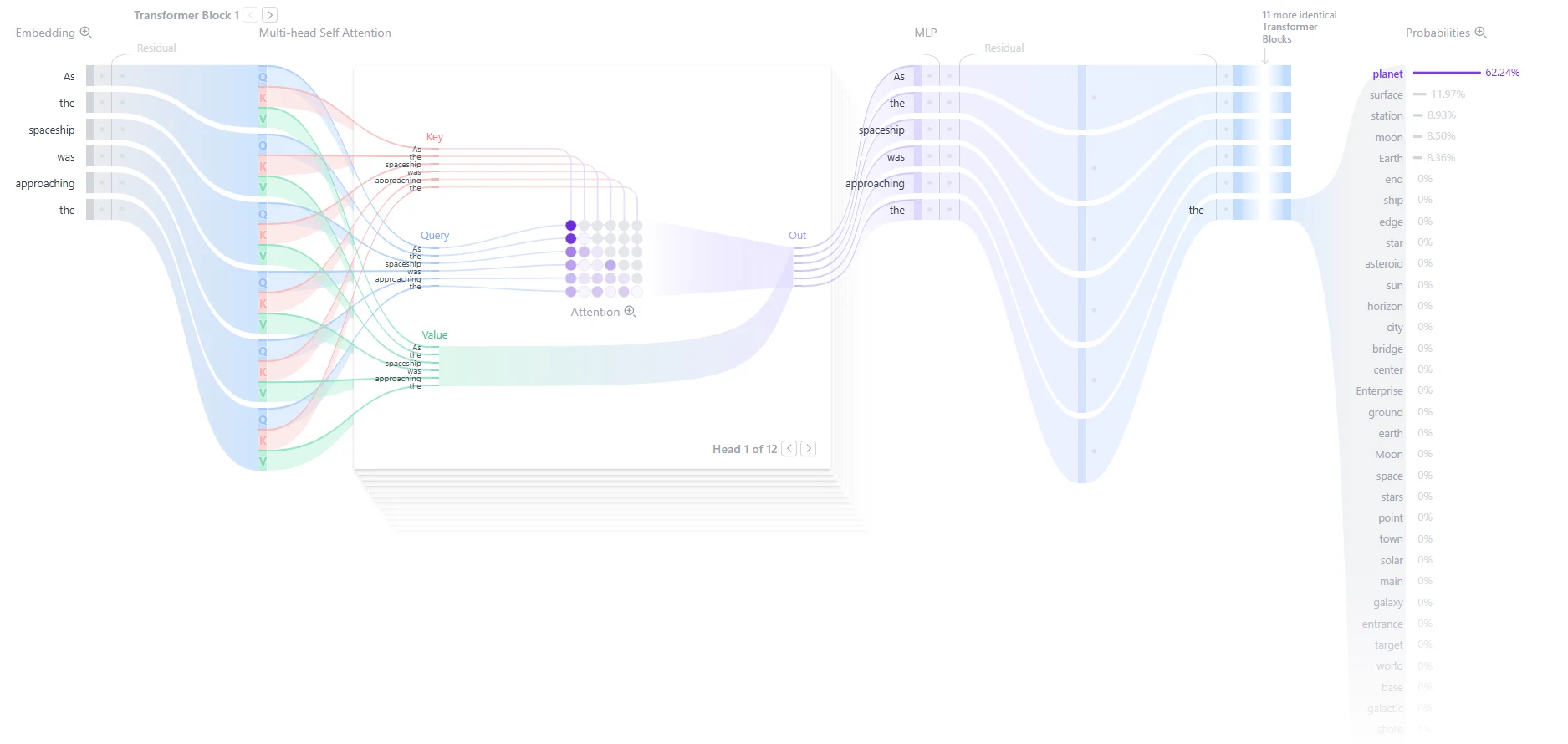

Juin 2017 marque une révolution silencieuse mais fondamentale avec la publication du papier "Attention is All You Need" par les équipes de Google. L'architecture Transformer introduit le mécanisme d'attention comme pierre angulaire du traitement séquentiel, abandonnant les architectures récurrentes traditionnelles au profit d'un parallélisme massif.

Le génie de l'architecture Transformer réside dans sa simplicité conceptuelle masquant une efficacité révolutionnaire. Contrairement aux réseaux récurrents qui traitent les séquences mot par mot dans l'ordre, les Transformers analysent simultanément tous les éléments d'une phrase, capturant instantanément les relations complexes entre termes distants.

Les innovations clés de l'architecture Transformer :

Le mécanisme d'auto-attention permet aux modèles de pondérer l'importance relative de chaque élément d'une séquence par rapport aux autres, capturant des dépendances à long terme avec une efficacité inégalée. Cette capacité à traiter simultanément tous les éléments d'une séquence divise les temps d'entraînement par des facteurs considérables tout en améliorant les performances.

L'architecture s'avère également remarquablement scalable, conservant son efficacité même avec l'augmentation massive du nombre de paramètres. Cette propriété devient cruciale pour le développement des grands modèles de langage qui suivront, permettant de passer de millions à des centaines de milliards de paramètres sans perte d'efficacité computationnelle.

Les avantages compétitifs des Transformers sur les architectures précédentes :

L'impact des Transformers se révèle progressivement à travers les modèles qui suivent. BERT en 2018 et GPT-1 la même année démontrent la polyvalence de cette architecture. Les Transformers deviennent rapidement l'architecture de référence, non seulement pour le langage naturel, mais aussi pour la vision par ordinateur et les applications multimodales.

Cette période de fondation bénéficie également d'une convergence favorable de facteurs externes. L'explosion des données numériques, la maturation des infrastructures cloud et l'émergence d'une génération de chercheurs formés aux méthodes modernes d'apprentissage automatique créent un environnement optimal pour l'innovation.

Cette période se caractérise par la convergence de plusieurs facteurs : la maturation des techniques de deep learning, l'émergence d'architectures révolutionnaires et la démonstration spectaculaire des capacités de l'IA. Ces éléments créent un momentum qui propulse l'intelligence artificielle vers son explosion grand public des années suivantes.

L'année 2018 inaugure l'ère des grands modèles de langage avec deux publications majeures qui redéfinissent le traitement automatique du langage naturel. OpenAI présente GPT-1 en juin, un modèle de 117 millions de paramètres basé sur l'architecture Transformer. Bien que modeste selon les standards actuels, GPT-1 démontre pour la première fois qu'un modèle pré-entraîné sur un corpus généraliste peut être fine-tuné efficacement sur des tâches spécifiques.

L'évolution des modèles GPT illustre parfaitement l'accélération technologique de cette période :

Les innovations techniques de GPT-1 qui révolutionnent le NLP :

BERT, publié par Google en octobre 2018, adopte une stratégie complémentaire en se concentrant sur la compréhension bidirectionnelle du contexte. Contrairement aux modèles autorégressifs comme GPT qui prédisent le mot suivant, BERT maîtrise les relations dans les deux directions d'une phrase, excellant dans les tâches de classification et de réponse à des questions.

La complémentarité entre GPT et BERT révèle deux philosophies distinctes du traitement linguistique. GPT excelle dans la génération créative et la continuation logique d'idées, tandis que BERT surpasse dans l'analyse et la compréhension de contenus existants.

Les forces comparatives de BERT vs GPT :

BERT excelle dans :

GPT excelle dans :

L'impact de ces modèles dépasse leurs performances techniques immédiates. Ils démocratisent l'accès à des capacités de traitement linguistique avancées, permettant à des développeurs sans expertise approfondie en NLP d'intégrer des fonctionnalités sophistiquées dans leurs applications. Cette accessibilité catalyse l'innovation dans des secteurs variés, de la relation client à l'analyse de documents juridiques.

Février 2019 marque un tournant éthique et technologique avec la publication initiale partielle de GPT-2 par OpenAI. Avec 1,5 milliard de paramètres, le modèle génère des textes d'une qualité si convaincante qu'OpenAI prend la décision inédite de ne pas publier immédiatement la version complète, invoquant les risques de désinformation massive.

Cette approche prudente d'OpenAI suscite des débats passionnés dans la communauté scientifique. D'un côté, les partisans de la science ouverte dénoncent une entrave à la recherche collaborative. De l'autre, les experts en sécurité saluent une prise de conscience des risques potentiels de ces technologies puissantes.

Les risques identifiés ayant motivé la publication progressive de GPT-2 :

La qualité textuelle de GPT-2 surprend par sa cohérence narrative et sa capacité à maintenir un style constant sur plusieurs paragraphes. Les tests révèlent des capacités émergentes troublantes : le modèle peut compléter des articles de presse, rédiger des essais argumentés et même générer du code informatique fonctionnel.

Le concept de "capacités émergentes" devient central dans l'analyse des grands modèles de langage. Ces capacités, non explicitement programmées mais émergeant spontanément de l'entraînement sur de vastes corpus, défient notre compréhension traditionnelle de l'apprentissage automatique et soulèvent des questions fondamentales sur la nature de l'intelligence artificielle.

GPT-3, lancé en mai 2020 avec 175 milliards de paramètres, représente un saut quantique dans l'évolution des LLM. Le modèle démontre des capacités de "few-shot learning" révolutionnaires, accomplissant des tâches complexes avec seulement quelques exemples.

Les capacités émergentes spectaculaires de GPT-3 :

L'architecture de GPT-3 révèle l'importance critique de l'échelle dans l'IA moderne. Le modèle nécessite 355 GPU-années pour son entraînement initial, consommant l'équivalent de 1300 MWh d'énergie, soit la consommation annuelle de 120 foyers américains. Ces chiffres illustrent l'ampleur des ressources nécessaires pour atteindre ces performances et soulèvent des questions sur la durabilité environnementale de l'IA.

Comment mesurer le ROI d’une implémentation IA en entreprise? Voici un article qui pourrait vous éclairer dessus: “ROI des outils IA en entreprise : 15 métriques essentielles à mesurer”

Parallèlement aux avancées en traitement du langage, l'IA démontre son potentiel révolutionnaire dans les sciences avec AlphaFold 2 en 2021. Ce système de DeepMind résout le problème du repliement des protéines, un défi scientifique vieux de cinquante ans, en prédisant avec une précision atomique la structure tridimensionnelle de 98% des protéines humaines connues.

Le défi du repliement protéique illustre parfaitement la complexité des problèmes que l'IA moderne peut désormais résoudre. Les protéines, composées d'enchaînements d'acides aminés, adoptent des formes tridimensionnelles complexes déterminant leurs fonctions biologiques. Prédire cette structure à partir de la simple séquence d'acides aminés représentait un défi computationnel considérable.

Les caractéristiques du défi du repliement protéique :

L'approche d'AlphaFold 2 combine l'apprentissage profond avec des connaissances spécialisées en biophysique, démontrant comment l'IA peut amplifier l'expertise humaine dans des domaines hautement techniques. Le système analyse les séquences d'acides aminés et les corrélations évolutionnaires pour prédire les structures complexes.

Cette période voit également l'émergence des premiers outils d'IA pratiques pour les développeurs. GitHub Copilot, lancé en version bêta en 2021, assiste les programmeurs en générant automatiquement du code à partir de commentaires en langage naturel. Cet outil révolutionne la programmation en accélérant significativement le développement.

Les applications métiers émergentes de l'IA en 2021 :

L'impact d'AlphaFold dépasse la communauté scientifique en démontrant la capacité de l'IA à accélérer drastiquement la recherche et développement. Les structures protéiques prédites deviennent immédiatement disponibles pour des millions de chercheurs mondiaux, catalysant des découvertes qui auraient nécessité des années d'expérimentation traditionnelle.

L'année 2021 marque également les premiers pas de l'IA dans la création visuelle avec DALL-E, capable de générer des images à partir de descriptions textuelles. Bien que les résultats soient encore imparfaits, cette première incursion de l'IA dans la créativité visuelle préfigure la révolution artistique qui suivra avec DALL-E 2 et ses concurrents.

Cette période d'explosion des modèles de langage établit les fondements technologiques et conceptuels de la révolution IA générative. Les capacités émergentes observées dans GPT-3, combinées aux succès spécialisés comme AlphaFold, démontrent que l'IA atteint un niveau de maturité permettant des applications pratiques à grande échelle.

Le 30 novembre 2022 constitue une date charnière dans l'histoire de l'intelligence artificielle avec le lancement de ChatGPT par OpenAI. En rendant accessible une interface conversationnelle intuitive basée sur GPT-3.5, OpenAI démocratise instantanément l'accès aux capacités avancées des grands modèles de langage.

Cette croissance explosive révèle un besoin latent massif pour des outils d'assistance cognitive accessible. Contrairement aux précédentes innovations technologiques nécessitant un apprentissage spécialisé, ChatGPT exploite l'interface la plus naturelle qui soit : la conversation en langage naturel.

Les records d'adoption pulvérisés par ChatGPT :

L'impact de ChatGPT transcende ses capacités techniques pour devenir un phénomène culturel et économique. L'interface conversationnelle naturelle permet à des utilisateurs sans formation technique d'exploiter des capacités d'IA sophistiquées pour la rédaction, l'analyse, la programmation et la résolution de problèmes complexes.

L'analyse de l'usage révèle des patterns fascinants reflétant la diversité des applications :

Cette diversité d'applications démontre la généralité remarquable des capacités linguistiques modernes et préfigure une transformation profonde des méthodes de travail.

La viralité de ChatGPT déclenche une course technologique mondiale entre les géants de la tech. Microsoft intègre rapidement la technologie dans ses produits Office et Bing, tandis que Google riposte avec Bard et Anthropic lance Claude. Cette compétition intense accélère l'innovation et améliore rapidement les performances, la sécurité et l'utilisabilité des IA conversationnelles.

L'année 2022 voit également l'émergence de l'IA générative d'images avec des outils comme DALL-E 2, Midjourney et Stable Diffusion. Ces systèmes révolutionnent la création visuelle en permettant à quiconque de générer des images de qualité professionnelle à partir de descriptions textuelles simples.

La technologie sous-jacente - les modèles de diffusion - représente une approche radicalement différente de la génération d'images. Contrairement aux GAN (Generative Adversarial Networks) dominants jusque-là, les modèles de diffusion apprennent à "débruiter" progressivement des images, permettant un contrôle plus fin et des résultats plus stables.

Les avantages des modèles de diffusion sur les GAN :

L'impact de ces outils sur les industries créatives est immédiat et profond. Designers, marketeurs, créateurs de contenu et même artistes traditionnels intègrent rapidement l'IA générative dans leurs workflows. Les temps de production s'effondrent, passant de semaines à quelques minutes pour certains types de créations.

Les transformations concrètes dans les métiers créatifs :

Design graphique :

Marketing et communication :

Industries du divertissement :

Cette révolution créative soulève simultanément des questions complexes sur la propriété intellectuelle, l'authenticité artistique et l'avenir des métiers créatifs. Les débats sur les droits d'auteur des œuvres générées par IA et l'utilisation d'œuvres existantes pour l'entraînement des modèles révèlent les tensions entre innovation technologique et cadres juridiques traditionnels.

L'évolution vers le multimodal s'accélère avec GPT-4 en mars 2023, capable de traiter simultanément texte et images. Cette capacité multimodale ouvre des applications révolutionnaires : analyse de documents complexes, description automatique d'images, assistance visuelle pour personnes malvoyantes, et diagnostic médical assisté par analyse d'imagerie.

Les capacités multimodales transformatrices de GPT-4 :

Sora d'OpenAI étend ces capacités à la génération vidéo en 2024, créant des séquences cinématographiques cohérentes à partir de prompts textuels. Cette progression vers des modèles vraiment multimodaux - traitant texte, images, audio et vidéo simultanément - préfigure des assistants IA capables de comprendre et créer dans tous les médiums humains.

La période 2023-2025 marque l'adoption massive de l'IA par les entreprises, avec 49% des organisations de plus de 10 employés utilisant des technologies d'IA en 2024. Cette croissance exponentielle, particulièrement visible dans les secteurs de l'information, de la communication et des services spécialisés, témoigne de la maturité commerciale des solutions d'IA.

L'adoption varie significativement selon les secteurs, comme l'illustre le tableau suivant :

Cette disparité reflète à la fois la maturité variable des solutions sectorielles et les différences de culture d'innovation entre industries. Les secteurs technologiques adoptent naturellement plus rapidement, tandis que les industries réglementées procèdent avec plus de prudence.

Les cas d'usage se diversifient rapidement à travers les fonctions d'entreprise :

Service client et relation client :

Opérations et productivité :

Recherche et développement :

Marketing et ventes :

L'émergence des agents IA autonomes en 2024 représente la prochaine frontière de cette évolution. Ces systèmes peuvent décomposer des tâches complexes en sous-objectifs, planifier des séquences d'actions et exécuter des workflows multi-étapes avec une supervision minimale.

Les caractéristiques distinctives des agents IA autonomes :

L'investissement massif dans l'écosystème IA alimente cette croissance, comme le montre l'évolution des financements :

Cette croissance financière exponentielle témoigne de la confiance croissante des investisseurs dans le potentiel commercial de l'IA et alimente un cercle vertueux d'innovation.

La France, avec 1000 startups IA et 16 licornes spécialisées, illustre cette dynamique globale. Cette effervescence économique crée un cercle vertueux où les investissements financent de nouvelles recherches qui produisent des applications commerciales générant à leur tour de nouveaux investissements.

Les bénéfices tangibles rapportés par les entreprises adoptant l'IA :

Cependant, cette transformation s'accompagne de défis organisationnels majeurs nécessitant une approche holistique :

Défis technologiques :

Défis humains et organisationnels :

Défis stratégiques et éthiques :

L'évolution de ces dix dernières années révèle une accélération continue qui ne montre aucun signe de ralentissement. L'IA est passée d'une curiosité technologique à une force transformatrice touchant tous les secteurs de l'économie et de la société. Cette trajectoire soulève des questions fondamentales sur l'avenir du travail, de la créativité et de l'intelligence humaine dans un monde où les machines excellent dans des domaines toujours plus vastes de la cognition et de la création.

Cette décennie de ruptures technologiques a transformé l'intelligence artificielle d'une promesse futuriste en réalité quotidienne, redéfinissant notre rapport au travail, à la créativité et à la connaissance. L'accélération observée depuis 2015 témoigne d'une dynamique d'innovation autoentretenue, où chaque avancée nourrit la suivante dans une spirale de perfectionnement continu.

Les leçons majeures de cette décennie transformatrice :

L'IA n'est plus simplement un outil ; elle devient un partenaire cognitif capable d'augmenter les capacités humaines dans des domaines toujours plus vastes. Cette transformation s'accompagne de défis considérables qui façonneront les années à venir.

Les enjeux critiques pour 2025-2030 :

L'horizon 2030 s'annonce déjà riche en défis et opportunités. Les débats actuels sur l'intelligence artificielle générale (AGI) et les investissements massifs dans cette direction suggèrent que les prochaines années pourraient voir naître des systèmes aux capacités véritablement générales.

Les entreprises qui sauront naviguer cette transformation en combinant innovation technologique et responsabilité sociétale seront celles qui prospéreront dans ce nouveau paradigme. L'IA ne remplace pas l'intelligence humaine ; elle l'amplifie, ouvrant des possibilités inédites pour ceux qui sauront s'adapter et évoluer avec ces technologies révolutionnaires.

Vous souhaitez anticiper ces transformations et intégrer stratégiquement l'IA dans votre organisation ?

Discutons-en.

Flowt accompagne les dirigeants dans leur transformation digitale grâce à l'expertise en IA, Data Science et Business Intelligence, pour transformer ces ruptures technologiques en avantages concurrentiels durables.

Vous souhaitez être accompagné pour lancer votre projet Data ou IA ?

Abramson, J., Adler, J., Dunger, J., Evans, R., Green, T., Pritzel, A., Ronneberger, O., Willmore, L., Ballard, A. J., Bambrick, J., Bodenstein, S. W., Evans, D. A., Hung, C., O’Neill, M., Reiman, D., Tunyasuvunakool, K., Wu, Z., Žemgulytė, A., Arvaniti, E., . . . Jumper, J. M. (2024). Accurate structure prediction of biomolecular interactions with AlphaFold 3. Nature, 630(8016), 493–500. https://doi.org/10.1038/s41586-024-07487-w

Cristofaro, M., & Giardino, P. L. (2025). Surfing the AI waves: the historical evolution of artificial intelligence in management and organizational studies and practices. Journal of Management History. https://doi.org/10.1108/jmh-01-2025-0002

Devlin, J., Chang, M.-W., Lee, K., & Toutanova, K. (2019). BERT: Pre-training of deep bidirectional transformers for language understanding. In Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies (pp. 4171-4186). Association for Computational Linguistics. https://doi.org/10.18653/v1/N19-1423

Dwivedi, Y. K., Kshetri, N., Hughes, L., Slade, E. L., Jeyaraj, A., Kar, A. K., Baabdullah, A. M., Koohang, A., Raghavan, V., Ahuja, M., Albanna, H., Albashrawi, M. A., Al-Busaidi, A. S., Balakrishnan, J., Barlette, Y., Basu, S., Bose, I., Brooks, L., Buhalis, D., … Wright, R. (2023). Evolution of artificial intelligence research in Technological Forecasting and Social Change: Research topics, trends, and future directions. Technological Forecasting and Social Change, 192, 122579. https://doi.org/10.1016/j.techfore.2023.122579

Jumper, J., Evans, R., Pritzel, A., Green, T., Figurnov, M., Ronneberger, O., Tunyasuvunakool, K., Bates, R., Žídek, A., Potapenko, A., Bridgland, A., Meyer, C., Kohl, S. A. A., Ballard, A. J., Cowie, A., Romera-Paredes, B., Nikolov, S., Jain, R., Adler, J., … Hassabis, D. (2021). Highly accurate protein structure prediction with AlphaFold. Nature, 596(7873), 583-589. https://doi.org/10.1038/s41586-021-03819-2

Silver, D., Huang, A., Maddison, C. J., Guez, A., Sifre, L., van den Driessche, G., Schrittwieser, J., Antonoglou, I., Panneershelvam, V., Lanctot, M., Dieleman, S., Grewe, D., Nham, J., Kalchbrenner, N., Sutskever, I., Lillicrap, T., Leach, M., Kavukcuoglu, K., Graepel, T., & Hassabis, D. (2016). Mastering the game of Go with deep neural networks and tree search. Nature, 529(7587), 484-489. https://doi.org/10.1038/nature16961

Silver, D., Schrittwieser, J., Simonyan, K., Antonoglou, I., Huang, A., Guez, A., Hubert, T., Baker, L., Lai, M., Bolton, A., Chen, Y., Lillicrap, T., Hui, F., Sifre, L., van den Driessche, G., Graepel, T., & Hassabis, D. (2017). Mastering the game of Go without human knowledge. Nature, 550(7676), 354-359. https://doi.org/10.1038/nature24270

Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., Kaiser, Ł., & Polosukhin, I. (2017). Attention is all you need. In Advances in Neural Information Processing Systems (Vol. 30, pp. 5998-6008). Neural Information Processing Systems Foundation. https://arxiv.org/abs/1706.03762

Boston Consulting Group. (2024). Where's the value in AI? Bridging the gap between AI investment and business impact. BCG Publications. https://www.bcg.com/publications/2024/wheres-value-in-ai

Deloitte AI Institute. (2024). State of generative AI in the enterprise: Q4 2024 survey series. Deloitte Global. https://www.deloitte.com/global/en/issues/generative-ai/state-of-generative-ai-in-enterprise.html